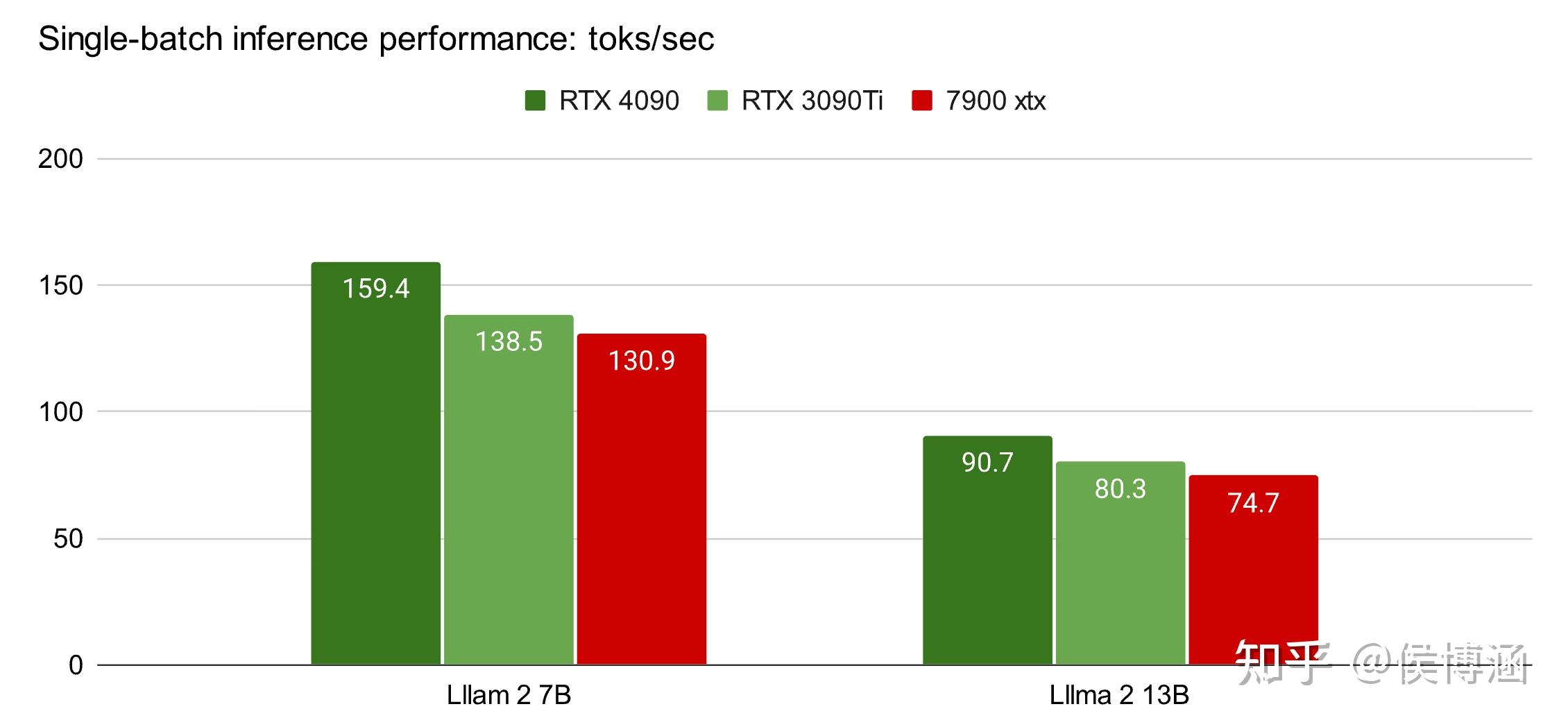

MLC-LLM 包可以利用 AMD 的 ROCm 进行大语言模型的编译及推理。性能方面,在 Llama2-7B/13B 上,7900 XTX 做推理可以达到 80% 4090 的水平

中文简介 https://zhuanlan.zhihu.com/p/649088095

英文原文 https://blog.mlc.ai/2023/08/09/Making-AMD-GPUs-competitive-for-LLM-inference

Github https://github.com/mlc-ai/mlc-llm/

A 卡炼丹开始好起来了?

内容版权声明:除非注明,否则皆为本站原创文章。